دكتور / صلاح عبد السميع

تعيش البشرية في عصر تحول رقمي سريع، حيث يشهد التقدم التكنولوجي تطورًا مذهلاً في مجال الذكاء الاصطناعي.

يعتبر الذكاء الاصطناعي التوليدي، أو القدرة على إنشاء برامج وأنظمة تكنولوجية قادرة على التفكير والتعلم بشكل مستقل، من أبرز التطورات في هذا المجال.

ومع زيادة قدرات الذكاء الاصطناعي التوليدي، ينبغي علينا أن نواجه ونناقش بشكل صادق وشامل المخاطر المحتملة المرتبطة بهذا التقدم التكنولوجي.

تُعَدُّ المخاطر المحتملة للذكاء الاصطناعي التوليدي من بين أبرز القضايا التي تثير قلق المجتمع العلمي والأخلاقي. فمع تمكن الأنظمة الذكاء الاصطناعي من تعلم الأنماط واتخاذ قرارات منطقية بشكل ذاتي، تطرح هذه القدرات تحديات أخلاقية وأمنية واقتصادية تستحق منا الانتباه.

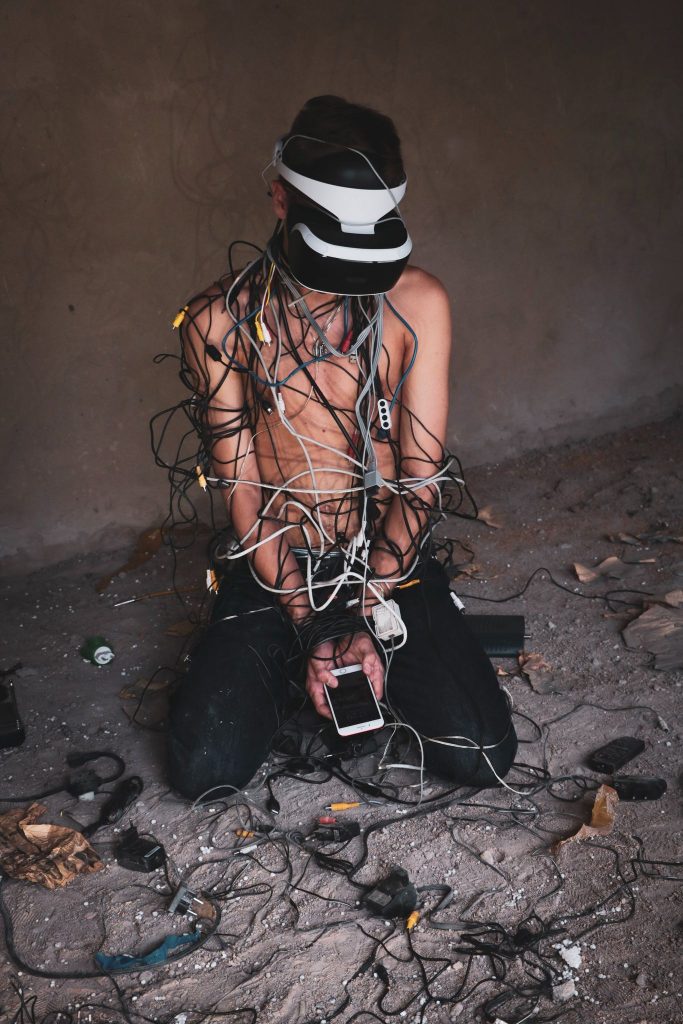

من بين المخاطر المحتملة للذكاء الاصطناعي التوليدي، يمكن ذكر تزايد الاعتماد على التكنولوجيا بشكل كبير وتقليل الاعتماد على البشرية في عمليات صنع القرار.

هذا يمكن أن يؤدي إلى فقدان السيطرة والتحكم البشري وزيادة المخاطر المحتملة في حالة وقوع أخطاء أو تجاوزات في الأنظمة الذكاء الاصطناعي.

ومن الأمور الأخرى التي تستحق الاهتمام هي التحديات الأخلاقية المرتبطة بالذكاء الاصطناعي التوليدي.

فبينما يمكن أن يكون الذكاء الاصطناعي قادرًا على ابتكار حلول متطورة وتحقيق تقدم علمي هائل، فإن له أيضًا القدرة على تكوين آراء وتأثير في قراراتنا وسلوكنا. يجب أن نسأل أنفسنا كيف يمكننا ضمان أن يتم استخدام هذه التقنية بطريقة أخلاقية وعادلة وتحقق مصلحة البشرية بشكل عام.

بالنظر إلى هذه المخاطر المحتملة، ينبغي أن نتبنى توصيات وإجراءات للتعامل معها.

يجب تعزيز البحث في مجال أخلاقيات الذكاء الاصطناعي وضمان تطبيق مبادئ الشفافية والمساءلة والمشاركة الفاعلة في تصميم وتطوير الأنظمة الذكاء الاصطناعي التوليدي.

يجب أيضًا تعزيز التعاون الدولي وإقامة إطار قانوني وأخلاقي قوي للتنظيم والمراقبة.

ينبغي أن تكون هناك لجان أخلاقية واضحة ومستقلة تقوم بتقييم وتوجيه استخدامات الذكاء الاصطناعي التوليدي وتحديد الحدود والتوجيهات الأخلاقية.

علاوة على ذلك، ينبغي أن نضمن وجود نهج تعليمي شامل يركز على الوعي بالتقنيات الذكاء الاصطناعي والتأكيد على القيم الأخلاقية والمسؤولية في استخدامها. يجب تعزيز البحث والتطوير في مجال تقنيات الذكاء الاصطناعي الآمنة والموثوقة، بما في ذلك آليات الحماية والتصحيح والتدقيق الذاتي.

ومن خلال البحث حول أهم التحديات والمخاطر التى ترتبط بالذكاء الاصطناعى التوليدى اتضح ان هناك العديد من المخاطر على المستوى السياسية والاقتصادية والاجتماعية والتقنية والقانونية والبيئية ، بالإضافة إلى بعض المؤشرات المحتملة لكل منها،مع استعراض للتوصيات وتلمقترحات التى ترتبط بكل بعد من تلك الأبعاد سالفة الذكر على النحو التالى :

المخاطر السياسية:

مخاطر:

تعديل التشريعات والقوانين التي تقيد استخدام الذكاء الاصطناعي.

تفاوت التنظيم والتشريعات بين البلدان تؤدي إلى عدم الاستقرار والتباين في القوانين.

التوصيات:

تطوير إطار قانوني شامل ومستدام للذكاء الاصطناعي يحفظ الحقوق والحريات ويضمن المساءلة.

تعزيز التعاون الدولي لوضع مبادئ ومعايير مشتركة لاستخدام الذكاء الاصطناعي.

المخاطر الاقتصادية:

مخاطر:

تأثير التكنولوجيا الذكاء الاصطناعي على فقدان فرص العمل وتغير سوق العمل.

تكلفة تطوير وتنفيذ الذكاء الاصطناعي وتأثيرها على استدامة الأعمال والتوسع الاقتصادي.

التوصيات:

توفير فرص عمل جديدة وتحديث المهارات لمواجهة التغيرات التكنولوجية.

دعم الابتكار والاستثمار في الشركات الناشئة والتكنولوجيا الذكية لتعزيز النمو الاقتصادي.

المخاطر الاجتماعية:

مخاطر:

زيادة الانقسام الاجتماعي وتفاقم العدالة الاجتماعية نتيجة للتمييز التكنولوجي أو فصل الطبقات.

تأثير الذكاء الاصطناعي على الخصوصية والسلامة الشخصية وتبديد الثقة في التكنولوجيا.

التوصيات:

تعزيز التوعية والتعليم حول الذكاء الاصطناعي وأخلاقياته في المجتمعات.

تضمين مبادئ العدالة والشفافية والتنوع في تصميم وتطوير النظم الذكاء الاصطناعي.

المخاطر التقنية:

مخاطر:

عدم الدقة والتحيز في نتائج الذكاء الاصطناعي وتأثيرها على صحة القرارات.

تهديد أمني واختراق الأنظمة الذكاء الاصطناعي واستغلالها في أغراض ضارة.

التوصيات:

تطوير أدوات ومنهجيات لضمان الدقة والشفافية والمساءلة في أنظمة الذكاء الاصطناعي.

تعزيز الأمن السيبراني وتطوير إجراءات الاحتياطات لحماية النظم الذكاء الاصطناعي من التهديدات الأمنية.

المخاطر القانونية:

تغييرات قوانين الخصوصية وحماية البيانات التي تؤثر على جمع واستخدام البيانات في الذكاء الاصطناعي.

قوانين تنظيمية جديدة أو عدم وجود تنظيمات كافية لمنع سوء استخدام أو تحديات أخلاقية للذكاء الاصطناعي.

التوصيات القانونية:

تطوير قوانين وتشريعات فعالة وشاملة لحماية البيانات والخصوصية في سياق استخدامات الذكاء الاصطناعي.

تشجيع التعاون الدولي وتبادل المعلومات لتطوير مبادئ ومعايير مشتركة للاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي.

المخاطر البيئية:

الآثار البيئية الناتجة عن استهلاك الطاقة العالي والموارد المادية في تطوير وتشغيل أنظمة الذكاء الاصطناعي.

تأثير استخدام الذكاء الاصطناعي على التنوع البيولوجي والبيئة الطبيعية.

التوصيات البيئية:

تعزيز البحث والتطوير لتطوير تقنيات الذكاء الاصطناعي الأكثر فعالية من حيث استهلاك الطاقة والموارد.

تشجيع استخدام الذكاء الاصطناعي للمساهمة في حل المشكلات البيئية مثل إدارة النفايات وحماية الحياة البرية.

الذكاء الاصطناعي

الذكاء الاصطناعي

وفيما يلي بعض التوصيات العامة لتقليل أثر هذه المخاطر:

تطوير إطار قانوني وسياسي شامل ومناسب للتكنولوجيا الذكاء الاصطناعي يحفظ الحقوق والحريات ويضمن المساءلة.

الاستثمار في برامج تعليمية وتعزيزي العميل، أعتذر عن الانقطاع المفاجئ في الرد. هنا هي المتبقية من إجابتي:

الاستثمار في برامج تعليمية وتدريبية لتعزيز الوعي والفهم حول الذكاء الاصطناعي وأخلاقياته.

تعزيز التعاون والحوار المستدام بين القطاعات المختلفة، بما في ذلك الحكومات والشركات والمجتمع المدني.

تشجيع البحث والابتكار في مجالات الذكاء الاصطناعي الأخلاقي وتطوير أدوات ومنهجيات لتقييم ومراقبة أثره الاجتماعي والبيئي والاقتصادي.

تعزيز المساءلة والشفافية في استخدام الذكاء الاصطناعي، بما في ذلك توفير الوسائل اللازمة للمستخدمين لفهم كيفية استخدام بياناتهم وحمايتها.

تشجيع الابتكار المستدام والمسؤول في مجال الذكاء الاصطناعي، بما في ذلك تطوير تقنيات تكون أكثر فاعلية من حيث استخدام الموارد وتقليل التأثير البيئي.

ودائما وابداً يجب أن نتعامل مع التقدم في مجال الذكاء الاصطناعي التوليدي بروح من التوازن والحذر، وأن نأخذ في الاعتبار العواقب المحتملة والتحديات الأخلاقية المرتبطة بهذه التكنولوجيا.

إن توجيه الجهود نحو تطوير واستخدام الذكاء الاصطناعي بشكل أخلاقي ومسؤول يمكن أن يسهم في تحقيق الفوائد المتنوعة لهذا المجال وتجنب المخاطر السلبية المحتملة.

جريدة الأهرام الجديد الكندية

جريدة الأهرام الجديد الكندية